硅基还是碳基?大模型与人类大脑

当我们让AI扮演自己的男友或女友,AI可能会通过极尽撩人的话术让人心跳脸红。在我们跟AI交互的过程中,我们有时候甚至会忘却它只是一个大模型或者一段代码。

大模型与人类大脑好像如此相似,实际上真的如此吗?本篇文章我们尝试浅显易懂的去理解大模型与人脑的相似和差异。

意识

首先,有智能不一定有意识,甚至有超级智能也不一定有自我意识。相反有意识一般都有智能,而自我意识可以兼容从低级到高级的不同智能。显然,现在的大模型,如ChatGPT(GPT-3.5或GPT-4o)还不具备意识,与人类大脑仍有差距。

模态

想象一下,你走进电影院,灯光渐暗,银幕亮起。你的眼睛捕捉着画面,耳朵聆听着对话和刺激的音效,甚至鼻子能嗅到爆米花的香味。这就是人脑的神奇之处——它能够同时处理视觉、听觉,甚至是嗅觉信息,将它们融合成一个完整的体验。

显然,人脑是可以处理多模态和跨模态任务的,而现阶段的大模型在多模态和跨模态尚处于早期阶段,因此仍然算不上通用智能。

模态(Modal)通常指的是一种特定的输入或输出方式,如视觉、听觉、触觉等。多模态(Multimodal)指的是能够同时处理多种模态数据的系统或技术。跨模态(Cross-Modal)指的是在不同模态之间进行信息转换或关联的能力。

结构

大模型和人脑的神经网络在结构和功能上确实存在一些相似之处,两者都具有层次化的结构,信息在多个层级中传递和处理。抽象的对标大模型和人脑:

编码成神经脉冲(即神经细胞的激活强度)

计算出连接关系(即神经连接的激活范围)

解码为感觉感受(即神经结构的激活模式)

转码成语言表达(即语言网络的神经脉冲)

训练

训练模式上,大模型跟人类大脑有着相似的逻辑。

人脑进行学习训练的过程中,培养锻炼推理与思辨的能力,是提高智能水平的关键,而这需要通过逻辑思维的训练来达成,如解题与编程。

大模型也需要通过“训练”来变得更聪明。它们学习的方式可以和我们学习编程或数学时的逻辑训练相似。数学和编程,就像是大脑的训练过程,因为它们都有非常严格的规则和逻辑。

所以,如果我们想让大模型变得更智能,我们可以先用编程语言“喂”它们,然后再用数学语言。这样做是因为编程和数学都是基于非常清晰和完整的逻辑系统构建的,它们帮助我们以最精确的方式表达思想。

简单来说,就像我们通过学习数学和编程来提高逻辑思维能力一样,大模型也可以通过学习这些“语言”来逐步提升它们的智能水平。

规模

大脑就像一个超级复杂的指挥中心,它由近860亿个微小的智能单元组成,我们称之为神经元。这些神经元相互之间通过一种叫做突触的连接点进行沟通,每个神经元平均有7000个这样的连接点。这些突触就像可调节的旋钮,可以增强或减弱神经元之间的连接强度,帮助大脑进行学习和适应。

如果把大脑的每个突触比作一个参数,那么人类大脑的参数规模就达到了惊人的100万亿级别,这比任何现有的人工智能模型都要庞大得多(当前大模型参数规模可达千亿左右)。这庞大的网络结构,正是我们进行理性分析和感性体验的生物学基础。

质量

智能并非仅由大脑或机器的参数数量决定,训练的质量同样至关重要。

"垃圾进,垃圾出"(Garbage In, Garbage Out)大家应该很熟悉,无论大脑还是机器,其输出的优劣完全取决于输入的质量。

对于大型模型而言,规模的扩张并非无止境。一旦达到某个阈值,单纯的规模增长将带来递减的边际效益。此时,唯有通过持续提供高质量的大数据进行训练,模型才能实现进一步的优化与提升。相比之下,人类历史上积累了千百年的人类文明,人们通过各种教育途径更容易获得高质量信息。

情绪

大模型能理解你的情绪吗?回到开头的例子,AI男友或女友看似是非常体贴和完美的,向用户提供了强大的情绪价值,但是它真的理解你的情绪吗?

大模型从人类语言中,学习到的的逻辑信息而不是情绪信息,AI男友女友的反馈本质上是逻辑反馈。相比之下,在人类的思维中,有些情绪模型是出厂自带的,也有些是后天的生活经验中习得的。

所以,智能高不代表就可以理解人类和共情人类,就像很多投机的网红博主装作与打工人共情,实际上是精细的计算。

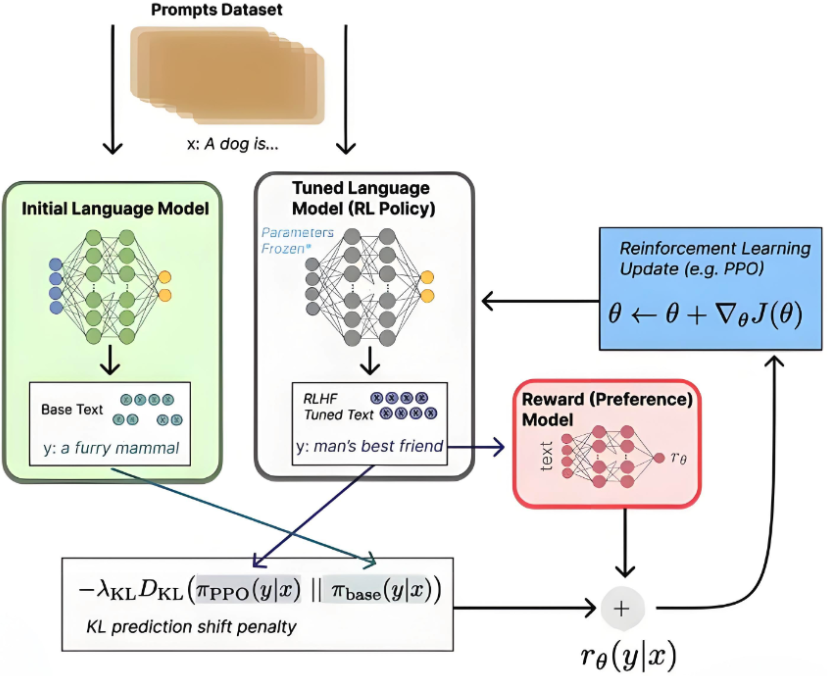

如果想要大模型理解人类情绪,并输出符合人类要求及需求的价值观、世界观与偏好预期,就需要它从人类的交互反馈中去学习迭代。通过与人类交互,根据人类的奖惩反馈,训练出一个奖励模型。

其实,比较大模型和人类大脑这样的微观议题,只是我们去尝试理解大模型和人工智能的一个切入点。当我们放眼地球上有碳基生命出现以来,在35亿年的历史中,目前人类是唯一拥有通用智能和自我意识的物种,那么在未来,硅基生命有没有可能成为新的物种?